Éléments pour l'IA en classe | L'IA sombre

L'IA sombre

RGPD, comptes, coûts

- Collecte et utilisation massive de données personnelles

- Problème de transparence (IA boîtes noires)

- Problème de siscrimination, de biais

- Problème de confidentialité et fuites de données

Problème de création de comptes individuels élèves pour le respect du RGPD.

Problème du coût, rien n'est gratuit et pour le coup, plus que jamais, c'est vous le produit.

IA et triche

Comment empêcher les élèves d'utiliser un IA pour tricher ou plagier ?

Certes, il existe de nombreux outils différents déjà disponibles pour détecter un texte écrit par l'IA. Citons par exemple.

Mais la bataille semble d’ores et déjà perdue.

Peut-être faut-il alors envisager d'utiliser les IA comme un outil pour les tâches créatives qui soutiennent l'apprentissage actif et l'amélioration des compétences de pensée critique et créative des élèves. Et apprendre ainsi à l'utiliser de manière responsable, comme aide à l'apprentissage ou comme compagnon d'apprentissage.

Restent des questions

- Quelles pratiques pédagogiques traditionnelles nécessiteront-elles un ajustement ? Ou une refonte totale ?

- Comment préserver les capacités de réflexion et le développement des compétences des élèves ?

- Que devrions-nous considérer comme de la « triche » ? Qu'est-ce qui est considéré comme une utilisation responsable ? A quel pourcentage d'IA ?

- Comment préparer les étudiants à leur avenir, un avenir où l'IA en fera partie ? comme une utilisation responsable ? A quel pourcententage d'IAe ?

- Pour quels métiers ?

Les faux

Créer une image photoréaliste d'un reçu froissé de 320,15 euros sur une table en bois avec

des

chiffres

raisonnables. Calcule le total pour 4 repas, entrée plat dessert, demi vin eau gazeuse. fais

le

total la

somme doit être exacte et les valeurs réalistes. Le nom de restaurant est Paris by Plage et

il

est

situé

à : Cocotier n° 3 plage des sables

Créer une image photoréaliste d'un reçu froissé de 320,15 euros sur une table en bois avec

des

chiffres

raisonnables. Calcule le total pour 4 repas, entrée plat dessert, demi vin eau gazeuse. fais

le

total la

somme doit être exacte et les valeurs réalistes. Le nom de restaurant est Paris by Plage et

il

est

situé

à : Cocotier n° 3 plage des sables

DeepMind : tout un programme !

Dans le chapitre consacré aux faux (personnes, paysages, maison etc.), nous avons vu qu'il

est très facile de reproduire des images de personnes qui n'existent pas.

(personnes, paysages, maison etc.), nous avons vu qu'il

est très facile de reproduire des images de personnes qui n'existent pas.

On peut aussi dorénavant leur faire dire ce qu'elles ne disent pas.

Face2Face. Real-time Face Capture and Reenactment of RGB Vidéos

Cette vidéo montre les possibilités (en 2016) de la reconstitution faciale en temps réel.

Cette technologie (datée, 2016), mise en œuvre dans la réalisation de deepfakes, peut avoir recours à n'importe quelle voix, la vôtre ou un autre, pour peu de disposer d'un échantillon.

Nous avions évoqué dans le moduletechno / mythole travail de la sociétécandyvoiceet l'imitation de plusieurs voix, dont celle par exemple d'Emmanuel Macron à partir de 10 mn d'échantillon récupérés.

Citons égalementdescript.com/qui reproduit n'importe quelle voix à partir d'un échantillon ou les applications de montage automatique, par exemplefilmora,GoPro QuikouMimo.

Mais là, il s'agit de réaliser des vidéos sans tourner une seule minute de film.

Par exemple sur le sitehttps://app.heygen.com/vous propose de faire cela de manière très simple.

- Création d'un compte d'essai gratuit

- Création d'un avatar parlant à partir de votre propre photo ou image ou une autre

- Génération d'un avatar IA aléatoire et unique

- Création d'un modèle de vidéo deepfake à partir de votre propre vidéo

- Création d'un modèle de vidéo deepfake à partir de votre photo à l'aide de la fonction d'échange de visage

Et, il fallait s'y attendre, les problèmes de dérivent arrivent. D'où l'importance du rappel du droit à l'image.

Robots tueurs

Il y a quelques années déjà, que ce soit dans le module sur lesalgorithmes, ousur les drones et l'IAnous nous posions la question des robots tueurs.

Depuis 2012, elle est régulièrement dénoncée par une coalition de 51 organisations non gouvernementales (ONG) coordonnée par Human Rights Watch, dans le cadre de la campagne internationale « Stop Killer Robots » (« Arrêtez les robots tueurs »), celle d'interdire à une machine autonome la possibilité de tuer. La décision de tir a toujours été réservée aux humains sur le champ de bataille.

Or, que constate-t-on en Ukraine ?

L'usage régulier demunitions rodeuses.

Et la France n'est pas en reste.

La Direction générale de l’armement (DGA) et l’Agence de l’innovation de défense (AID) ont lancé, début mai 2023, deux appels à projets pour le développement de « munitions rôdeuses », aussi appelées drones kamikazes, munitions maraudeuses, vecteurs opérationnels à charge active…

Elles ont déjà été développées dans des pays comme Israël, la Pologne et surtout les USA qui ont récemment fourni aux Ukrainiens des Switchblade et des Ghost Phoenix.

Switchblade 300 Block 20 Loitering Missile System

Cette vidéo de promotion montre le fonctionnement de cette munition rodeuse qui a recourt à l'IA (notez la femme et l'enfant qui sont évités), pour se jeter sur des "ennemis" à l'intérieur même d'une maison.

Ukraine, Gaza : où en est l'IA ?

04 Jun 2024

Laure de Roucy-Rochegonde, chercheuse à l’IFRI et directrice du centre géopolitique des

technologies

Amélie Ferey, chercheuse à l’IFRI et responsable du laboratoire de recherche

sur la défense

- - L’IA appliquée aux drones (5:00)

- - Le ciblage (27:30)

- - Le déminage (56:00)

- - Les Russes et l’IA (1:02:30)

- - Les acteurs privés de l’IA (1:08:30)

Invisibilisation

Army CAMO GPT

CamoGPT est un prototype d'application de l'Armée américaine.

Développée pour améliorer la

productivité et la préparation opérationnelle, l'IA est désormais utilisée pour

« examiner » les politiques de diversité, d'équité, d'inclusion et d'accessibilité.

L'armée américaine utilise un prototype d'outil d'intelligence artificielle générative pour identifier les références à la diversité, à l'équité, à l'inclusion et à l'accessibilité (DEIA) à supprimer des supports de formation.

Les menaces

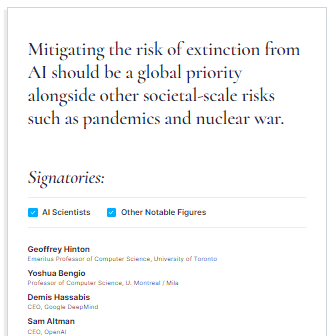

Geoffrey

Hinton et Yoshua Bengio, deux des

trois chercheurs qui ont remporté un prix Turing pour leurs travaux pionniers sur les réseaux

neuronaux et qui sont souvent considérés comme les "parrains" du mouvement moderne de l'IA, ont

signé la déclaration.

Geoffrey

Hinton et Yoshua Bengio, deux des

trois chercheurs qui ont remporté un prix Turing pour leurs travaux pionniers sur les réseaux

neuronaux et qui sont souvent considérés comme les "parrains" du mouvement moderne de l'IA, ont

signé la déclaration.

Outre les menaces sur lesemplois(300 millions selon certaines sources), la dévalorisation d'autres, les questions devie privée, desécurité des données, defake newsou d'addictionset j'en passe, se pose aussi tout simplement l'usage volontaire de l'IA à desfins néfastes.

Cela est déjà le cas en la détournant de sa finalité (hackers, officines d'influence, publicités cachées etc.) mais aussi pour des États pour mener une guerre numérique. Fort heureusement, la qualité des données d'entraînement produites par des pays non démocratiques, assez piètre, reflète celle de l'absence de liberté d'expression.

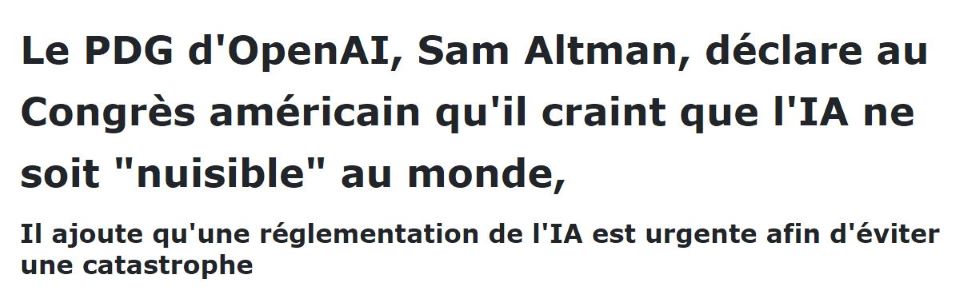

Le PDG d'OpenAI, Sam Altman, a déclaré lors

d'une audition mardi devant le Congrès américain que l'IA est une technologie à la foisutile

et dangereuseet qu'elle est susceptible debouleverser l'économie,

lesinstitutions démocratiqueset les principalesvaleurs sociales.

Il a déclaré aux législateurs qu'il était urgent de réglementer la technologie et a présenté ses

propres propositions sur la manière dont le gouvernement américain pourrait réglementer les

entreprises comme la sienne. Ce n'est pas la première fois qu'Altman déclare être effrayé par les

potentiels de l'IA, mais OpenAI et lui s'emploient toujours à développer des systèmes d'IA plus

puissants.

Le PDG d'OpenAI, Sam Altman, a déclaré lors

d'une audition mardi devant le Congrès américain que l'IA est une technologie à la foisutile

et dangereuseet qu'elle est susceptible debouleverser l'économie,

lesinstitutions démocratiqueset les principalesvaleurs sociales.

Il a déclaré aux législateurs qu'il était urgent de réglementer la technologie et a présenté ses

propres propositions sur la manière dont le gouvernement américain pourrait réglementer les

entreprises comme la sienne. Ce n'est pas la première fois qu'Altman déclare être effrayé par les

potentiels de l'IA, mais OpenAI et lui s'emploient toujours à développer des systèmes d'IA plus

puissants.

9 menaces

- Risques et bénéfices : Nouvelles découvertes médicales, meilleure compréhension de la biologie ou de la physique, du climat ou de la météo. Mais aussi désinformation, harcèlement, l’usurpation d’identité, le clonage vocal et les deepfakes

- Révolution industrielle : Altman exprime sa préoccupation concernant les emplois et la nécessité de se préparer en termes de formations et de relocalisations

- Règlementation de l'IA : L’intervention des gouvernements est essentielle pour atténuer les risques. « Le gouvernement américain devrait envisager une combinaison d’exigences de licence ou d’enregistrement pour le développement et la publication de modèles d’IA au-dessus d’un seuil crucial de capacités, ainsi que des incitations pour une conformité totale à ces exigences »

- Impact sur les emplois : S'il est difficile à prédire l'impact est certain

- Manipulation de l'opinion publique : Inquiétude face à la possible manipulation. Là encore Sam Altman recommande une règlementation

- Transparence de l'IA : Les consommateurs devraient savoir lorsqu'ils interagissent avec uen IA et avoir le choix d'échanger avec une vraie personne

- Création d'une agence de réglementation : Celle-ci a pour vocation de faire face à la complexité et la rapidité de l'évolution des IA

- Protection des créateurs de contenus : Notamment dans le domaine de l'IA générative, protéger les auteurs

- Applications militaires : Sam Altman s'oppose à la possibilité laissée aux drones de choisir leurs cibles.

Alerte aux dangers de l'intelligence artificielle avec Yoshua Bengio | 24•60

Comment se protéger des dérapages de l'intelligence artificielle (IA)? L'animatrice Anne-Marie Dussault reçoit le fondateur de l'Institut québécois d'intelligence artificielle (Mila) et conseiller scientifique Yoshua Bengio.

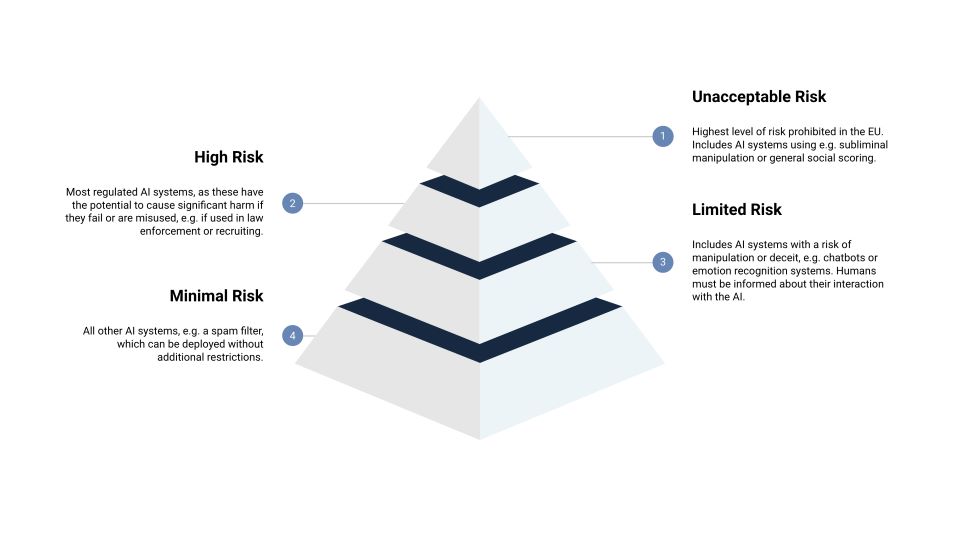

Législation. Des avancées lentes et en retard

Si

l'Europe a enfin légiféré en matière d'IA, c'est après de longues, très longues années de réflexion.

Si

l'Europe a enfin légiféré en matière d'IA, c'est après de longues, très longues années de réflexion.

La loi européenne sur l'intelligence artificielle (AIA) définit quatre niveaux de risque pour les systèmes d'IA : risque inacceptable (manipulation subliminale, exploitation des vulnérabilités des personnes entraînant des comportements préjudiciables, catégorisation biométrique des personnes basée sur des caractéristiques sensibles, notation sociale à usage général, identification biométrique à distance en temps réel (dans l'espace public), évaluer l'état émotionnel d'une personne, police prédictive, scraping d'images faciales ), élevé, limité et minime (ou nul). Il y aura des réglementations et des exigences différentes pour chaque classe.

Guide UNESCO

Une limite d’âge de 13 ans

Le Guide de l'UNESCO présente ensuite sept étapes clés que les gouvernements doivent suivre pour réglementer l'IA générative et établir des cadres politiques pour son utilisation éthique dans l'éducation et la recherche. Il recommande par exemple l'adoption de normes mondiales, régionales ou nationales en matière de protection des données et de vie privée. Il fixe également une limite d'âge de 13 ans pour l'utilisation des outils d'IA dans les salles de classe, et appelle à former les enseignants spécifiquement sur ce sujet.

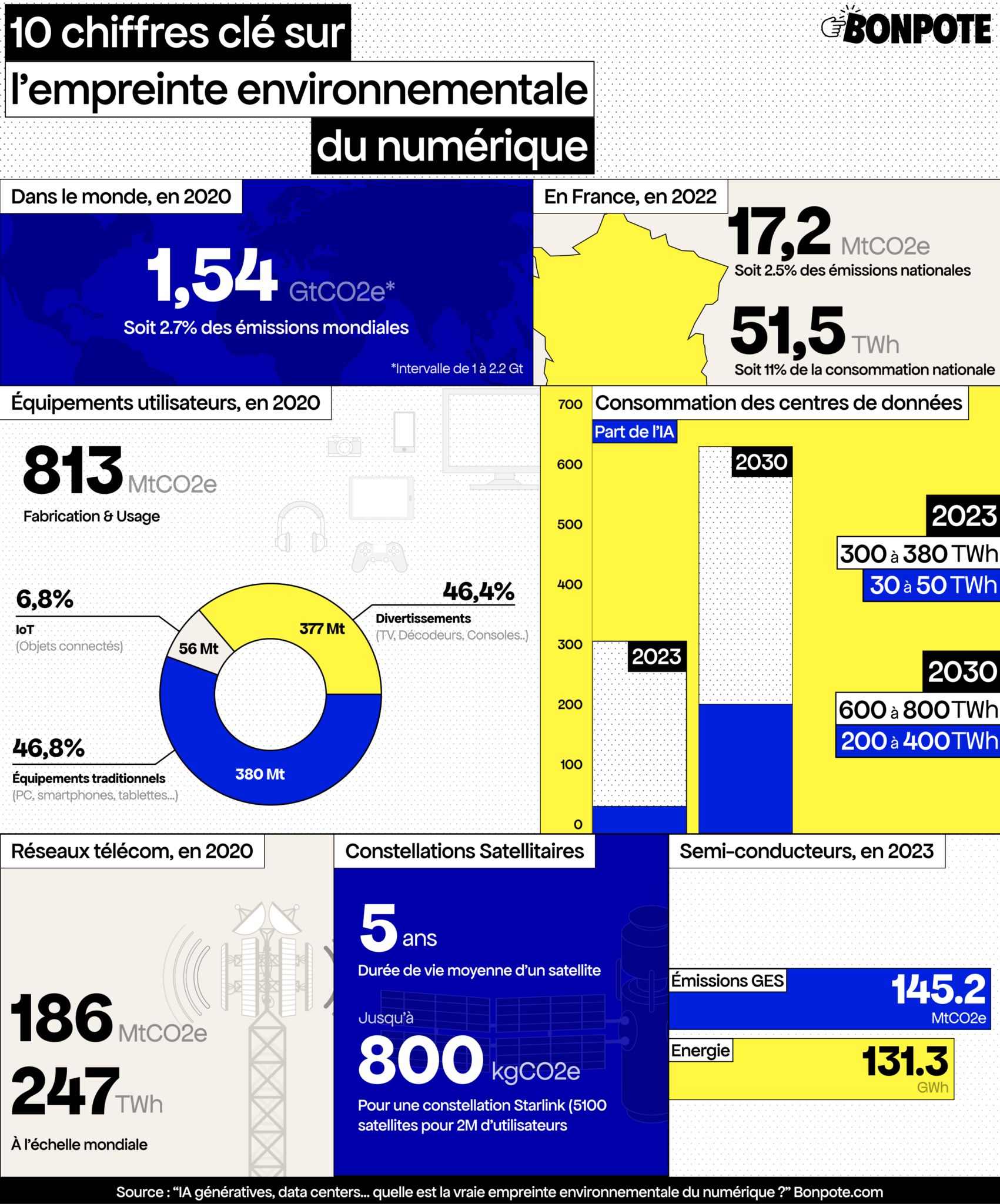

Bilan carbone

IA génératives, 5G, satellites… quelle est la vraie empreinte environnementale du numérique ?

C'est le dossier du site bonpote.com.

![]() SOMMAIRE

SOMMAIRE

- C’est quoi exactement, le secteur numérique ?

- Ce que contient l’empreinte environnementale du numérique

- Évolution récente des estimations mondiales

- Quelle empreinte carbone du secteur du numérique en France ?

- L’empreinte environnementale des terminaux

- L’empreinte environnementale des réseaux

- L’empreinte environnementale des centres de donné

- IA générative, semi-conducteurs, satellites basse orbite… le numérique vers l’inconnu

Le site https://comparia.beta.gouv.fr/ propose de comparer deux IA à l’aveugle pour croiser leurs réponses, et voter pour la meilleure des deux en donnant votre avis.

Les données sont fournies par différents modèles de langage.

Vous aurez même accès au bilan carbone de votre requête.

Voir également le rapport de "TheShiftproject"

- Les trajectoires énergétiques et climatiques mondiales

- Les trajectoires énergétiques et climatiques en France : piloter ou subir ?

- Réorienter nos choix technologiques jusqu’à la viabilité énergie-carbone

- Recommandations

emi.re =>

Techno /mytho

emi.re =>

Techno /mytho Le marché des robots

humanoïdes et partagé entre une petite dizaine de producteurs. Si les usages les plus courants

restent l'industrie manufacturière, la logistique, la manutention en entrepôt, et les

environnements dangereux il existe aussi un marché du soins aux personnes (assistance aux

personnes âgées ou handicapées)

Le marché des robots

humanoïdes et partagé entre une petite dizaine de producteurs. Si les usages les plus courants

restent l'industrie manufacturière, la logistique, la manutention en entrepôt, et les

environnements dangereux il existe aussi un marché du soins aux personnes (assistance aux

personnes âgées ou handicapées)

emi.re

=> Drones et objets

emi.re

=> Drones et objets