Les réseaux de neurones

L’idée des

réseaux de neurones prend donc un peu de corps avec Frank Rosenblatt et son

fameux Perceptron dès 1958. Perceptron est une sorte de neurone artificiel

capable d'apprendre à reconnaître des formes simples.

Ce fut un

petit succès… jusqu’à ce que Marvin Minsky et Seymour Papert publient en 1969 un livre

qui cassait un peu l’ambiance en montrant les limites sévères du

perceptron.

Ce fut un

petit succès… jusqu’à ce que Marvin Minsky et Seymour Papert publient en 1969 un livre

qui cassait un peu l’ambiance en montrant les limites sévères du

perceptron.

En effet, le Perceptron se révélait incapable de résoudre le problème XOR ("ou exclusif") :

Les opérateurs booléens de base :

ET (AND) : Vrai uniquement si les deux entrées sont vraies.

Exemple : 1 ET 1=11 \text{ ET } 1 = 11 ET 1=1, sinon 000.

OU (OR) : Vrai si au moins une des entrées est vraie.

Exemple : 0 OU 1=10 \text{ OU } 1 = 10 OU 1=1

SAUF (NOT) : Inverse la valeur de l'entrée.

Exemple : SAUF 1=0\text{SAUF } 1 = 0 SAUF 1=0

Le problème XOR

Le XOR ("ou exclusif") est vrai uniquement si une seule des entrées est vraie, mais pas les deux

en même temps.

Voici sa table de vérité

| x₁ |

x₂ |

x₁ XOR x₂ |

| 0 |

0 |

0 |

| 0 |

1 |

1 |

| 1 |

0 |

1 |

| 1 |

1 |

0 |

Le XOR peut être exprimé en combinant les opérateurs ET, OU, et SAUF :

x₁ XOR x₂=(x₁ ET SAUF x₂) OU (SAUF x₁ ET x₂)\text{x₁ XOR x₂} = (\text{x₁ ET SAUF x₂}) \text{ OU

} (\text{SAUF x₁ ET x₂})x₁ XOR x₂=(x₁ ET SAUF x₂) OU (SAUF x₁ ET x₂)

Le Perceptron ne peut pas résoudre le XOR parce qu'il ne peut pas combiner plusieurs règles

(comme ET, OU, et SAUF) en une seule étape.

Résultat : hiver nucléaire sur le domaine pendant une décennie ou deux.

Autrement dit la théorie existait déjà, mais la pratique n'en

était

qu'aux

balbutiements. Il manquait quelque chose, et ce quelque chose c'était les datas

caractérisées.

Sans le Big Data (données immenses), le Machine Learning et l’intelligence artificielle seraient

restés des sciences de laboratoire comme elles le sont depuis 50 ans.

Les données, et encore plus lorsqu'elles sont

catégorisées, sont l’instrument qui permet à l’IA de comprendre et d’apprendre.

C’est le Big Data qui permet d’accélérer la courbe d’apprentissage et permet l’automatisation des

analyses de données. Plus un système Machine Learning reçoit de données, plus il apprend et plus

il

devient précis.

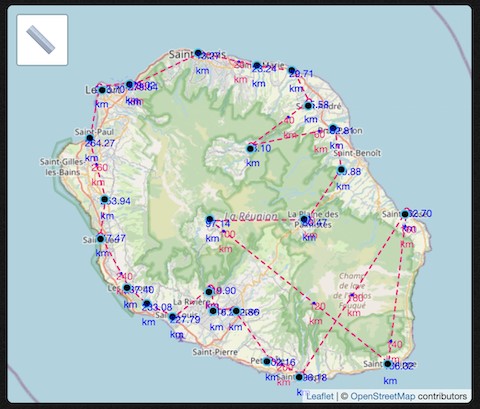

Aspirer le Web

Il existe des sites spécialisés, y compris en opensource, qui proposent une copie quasi

complète

de tout le Web.

Common Crawl est une organisation à but non lucratif 501(c)(3) fondée en

2007

qui ajoute de 3 à 5 milliards de nouvelles pages chaque mois.

commoncrawl.org/

commoncrawl.org/

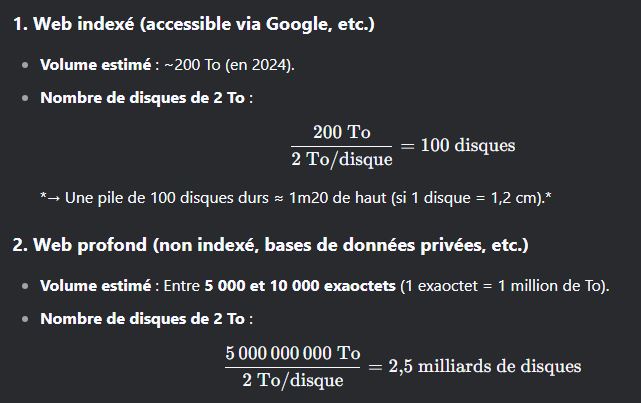

100 disques durs de 2 Tera pour le Web indexé

et 2.5

milliards pour le Web profond.

Mais quelle hauteur feraient tous ces disques empilés ?

Parler de l'IA nécessite aussi d'évoquer la difficulté que nous avons à penser l'immensité,

les

grands nombres.

Prenons les distances.

Un mètre, une centaine de mètres, un millier, un million, un

milliard…

1 000 000 000 m

Terre → Jupiter

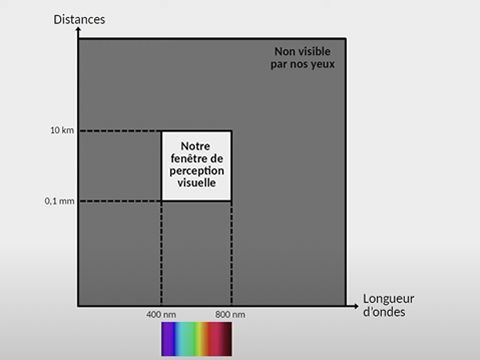

Deux autres exemples dans la compréhension du vivant pour faire une analogie. Il s'agit de

notre

fenêtre de perception visuelle, des couleurs ou des tailles ou des particules, par exemple

le photon

gamma…

Nous ne voyons pas dans l'infrarouge (cas des serpents) ou dans l'ultra violet, et si nous

pouvons

apercevoir des objets de moins de 0,1 mm ou a plus de 10 km, nous n'en avons pas de

perception

spatiale.

Telle étoile est-elle plus ou moins loin que telle autre ?

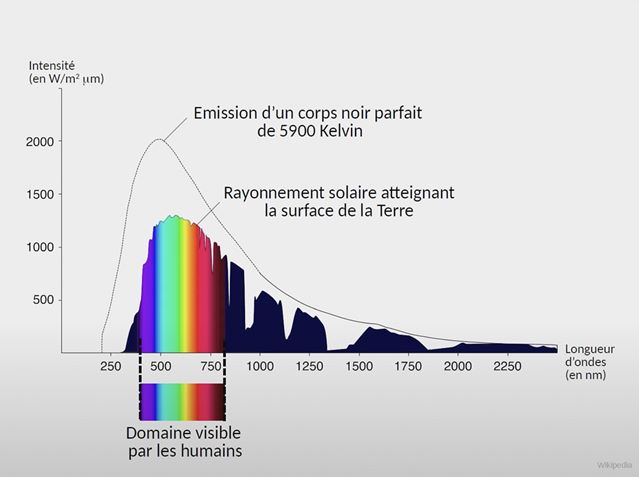

La lumière visible émise par le soleil n'est qu'une partie de celle émise.

Il émet des

photons,

ces particules qui voyagent à 300.000 kilomètres par seconde et sont si fines que certaines

peuvent

nous traverser. Et quand ce sont des photons gamma, leur traversée n'est pas sans risque…

y

compris de fake news.

Sur ce sujet, l'on pourra par exemple écouter le podcast de Xavier de la Porte, Pourquoi la

nanoparticule s’est-elle retrouvée dans tous les complots ?

Podcast nanoparticule

Podcast nanoparticule

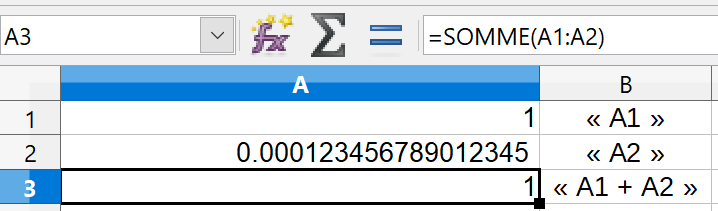

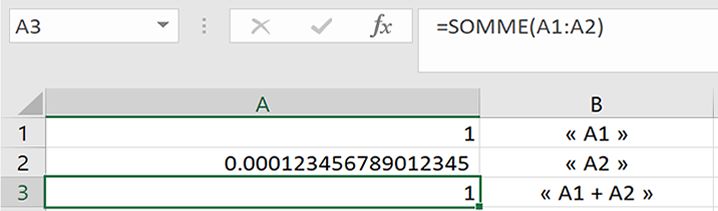

Un ordinateur est-il fiable ?

Outre les possibles erreurs de calcul liées à de sombres histoires de virgules flottantes, se

posent

également les problèmes de fuites ou de saturation de mémoire. Les fuites de mémoire se

produisent

lorsque les programmes ne parviennent pas à libérer les ressources mémoire dont ils n’ont

plus

besoin. Cela se traduit par des problèmes de performances. En termes simples, votre

ordinateur

manque de mémoire.

Un exemple

Le nombre maximum de lignes qu'un tableur Excel peut afficher et d'à peine un peu plus

d'un

million, plus exactement 1 048 576 lignes et 16 384 colonnes. Un tout petit

nombre

comparé aux données traitées par l'IA.

Notons ici également qu'un tableur, comme tout ordinateur, fait des

erreurs.Et

des erreurs non pas par erreur mais par sa programmation même.

Testons un calcul simple :1 + 0.000123456789012345

Ce calcul qu'un élève de CM2 saurait faire, un tableur de type Excel ou OpenOffice le

fait-il ?

Dans le même ordre d'idées, un calcul de type 0.1 + 0.2, au lieu d'obtenir un 0.3 parfait,

donne

quelquefois un résultat comme 0.30000000000000004.

Ou encore, calculer 1/824633702441.0.

Simple me direz-vous !

Et pourtant une

erreur de

division à virgule flottante dans ses processeurs Pentium a entraîné leur remplacement

inconditionne.

Prix de l’erreur : 475 millions de dollars.

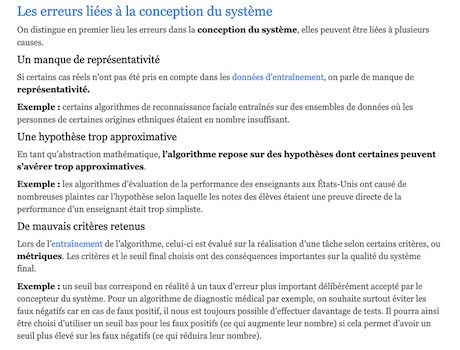

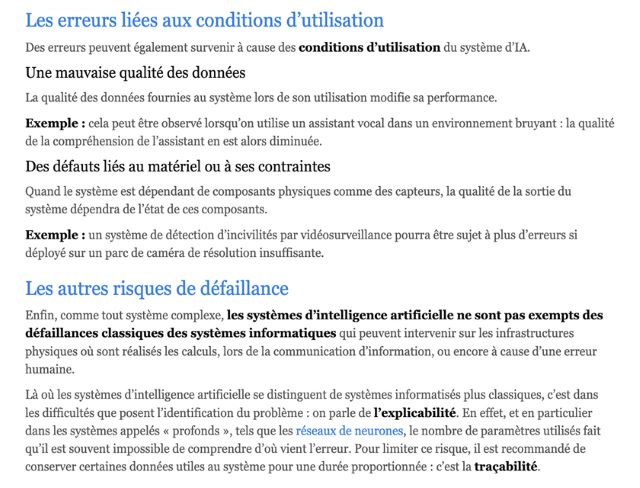

Pourquoi une IA fait-elle des erreurs ?

Étant donné la complexité des systèmes utilisant l’intelligence artificielle, les sources

d’erreur

peuvent être multiples.

L'IA est en train de s'empoisonner ?

Qu'est-ce que l'effondrement des modèles ?

L'effondrement des modèles est un processus dégénératif qui affecte les générations

successives de modèles génératifs appris, dans lequel les données qu'ils génèrent finissent

par polluer l'ensemble d'entraînement de la génération suivante, les conduisant à mal

percevoir la réalité.

Causes principales :

- Erreur d'approximation statistique (échantillons finis)

- Erreur d'expressivité fonctionnelle (limitations des réseaux de neurones)

- Erreur d'approximation fonctionnelle (limitations des procédures d'apprentissage)

Pour maintenir l'apprentissage sur le long terme, il est nécessaire de préserver l'accès aux

sources de données originales et de s'assurer que des données non générées par des LLM

restent disponibles dans le temps. Les événements à

faible probabilité, souvent pertinents pour les groupes marginalisés, sont particulièrement

menacés par ce phénomène.

Vers un risque d’effondrement des IA génératives ?

Que se passe t’il si un modèle d’intelligence artificielle (IA) générative s’entraine sur une proportion de plus en plus importante d’images auto-générées ? C'est à cette question que Quentin Bertrand, chargé de recherche au centre Inria de Lyon et membre de l’équipe-projet Malice a tenté de répondre.

Les joueurs en ligne

Si

l'IA a

connu ce développement c'est grâce à un seul acteur, Nvdia, le célèbre fabriquant de

cartes

graphiques. Nvidia récolte ainsi les fruits d’une vision de l’informatique “accélérée”,

couplant

les CPU avec des GPU pour contourner les limites de la loi de Moore.

Si

l'IA a

connu ce développement c'est grâce à un seul acteur, Nvdia, le célèbre fabriquant de

cartes

graphiques. Nvidia récolte ainsi les fruits d’une vision de l’informatique “accélérée”,

couplant

les CPU avec des GPU pour contourner les limites de la loi de Moore.

La petite entreprise californienne créée avec 40 000 dollars vaut désormais plus de

1000

milliards.

Contrairement au CPU qui exécute les instructions des programmes informatiques, le GPU

créé par

Nvidia se concentre sur le calcul des visuels et leur rendu.

Le groupe américain historiquement dédié aux jeux vidéo envahi désormais les data

centers, qui représentent désormais plus des trois quarts de son activité et 80% du

marché

global de l'IA.

L’IA

générative requière une

immense puissance de calcul pour son entraînement ou son fonctionnement. Ce sont

donc des

processeurs Nvidia qu'utilise OpenAI pour donner vie aux requêtes des utilisateurs

de

ChatGPT.

Microsoft détient ainsi plus de 10.000 cartes graphiques Nvidia A100.

L’IA

générative requière une

immense puissance de calcul pour son entraînement ou son fonctionnement. Ce sont

donc des

processeurs Nvidia qu'utilise OpenAI pour donner vie aux requêtes des utilisateurs

de

ChatGPT.

Microsoft détient ainsi plus de 10.000 cartes graphiques Nvidia A100.

Résultat. Pour la première fois Nvidia passe devant Intel en capitalisation

boursière.

Sam Altman, le patron d'OpenAI, s'efforce de mettre en place une

initiative

technologique de 7000 milliards de dollars visant à renforcer les capacités mondiales de

fabrication de puces d'IA. Une initiative qui vise à lever les contraintes qui entravent

le

développement de la GenAI… et lutter contre la position de monopole de Nvidia.

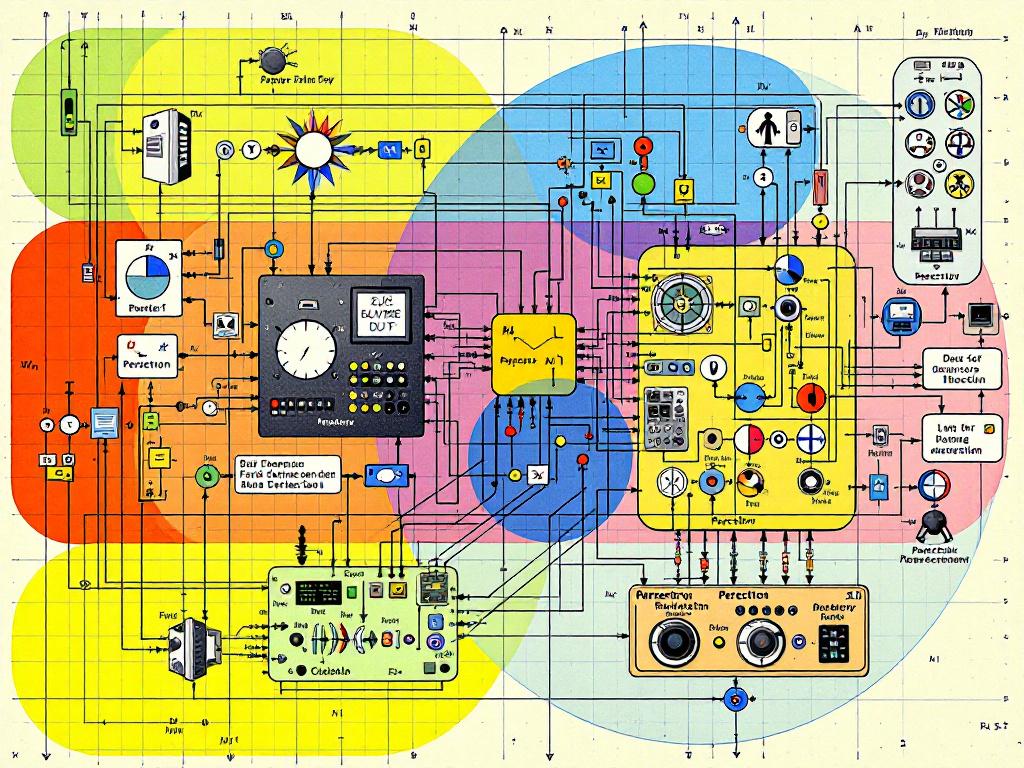

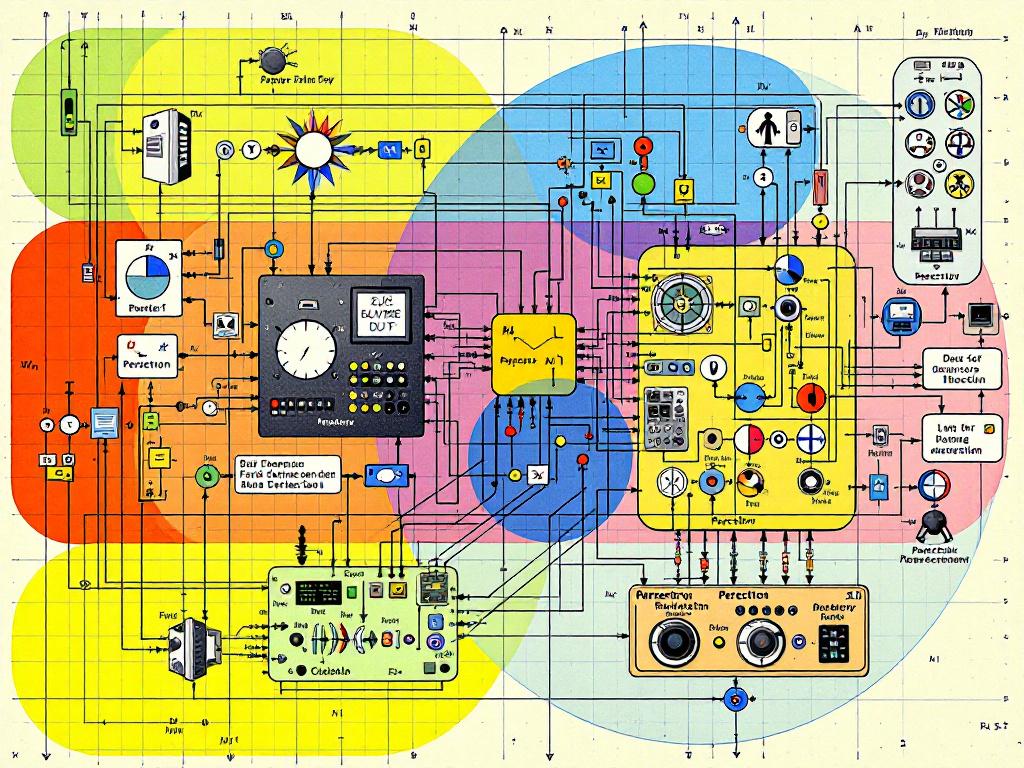

En résumé, l’IA préfère les cartes graphiques (GPU) aux "gros ordinateurs" classiques (avec

CPU) :

- Parce qu’un GPU fait plein de petits calculs en parallèle.

Un CPU

(processeur central) est très bon pour exécuter quelques tâches complexes à la fois,

avec

beaucoup de logique. Un GPU (processeur graphique), lui, est conçu pour faire des

milliers de

calculs simples en même temps (à l’origine : pour les pixels !). Le deep

learning

repose

sur des millions de multiplications de matrices.

- Parce qu’un modèle d’IA, c’est du sport intensif.

Entraîner un

modèle IA, ce

sont des milliards de paramètres à ajuster. Les GPU sont taillés pour cette

charge : des

calculs massifs, répétitifs, et en rafale. Un CPU, même très puissant, serait vite

débordé (ou

très, très lent).

- Parce que c’est beaucoup plus rapide (et rentable).

Entraîner un

modèle sur

un CPU prendrait des siècles. Sur un ensemble de GPU (ou des TPU, encore plus

spécialisés), cela

prend quelques semaines. Et le temps, c’est… de l’énergie et de l’argent.

Nous avons ainsi les 3 ingrédients qui ont rendus le succès

mondial

possible :

- La technologie des réseaux de neurones

- des données en masse

- une puissance de calcul

L’IA

est en réalité une discipline

jeune d’une soixante d’années, qui réunit des sciences, théories et techniques

(notamment logique mathématique, statistiques, probabilités, neurobiologie computationnelle et

informatique) et dont le but est de parvenir à faire imiter par une machine les capacités cognitives

d’un être humain.

L’IA

est en réalité une discipline

jeune d’une soixante d’années, qui réunit des sciences, théories et techniques

(notamment logique mathématique, statistiques, probabilités, neurobiologie computationnelle et

informatique) et dont le but est de parvenir à faire imiter par une machine les capacités cognitives

d’un être humain.

Ce fut un

petit succès… jusqu’à ce que Marvin Minsky et Seymour Papert publient en 1969 un livre

qui cassait un peu l’ambiance en montrant les limites sévères du

perceptron.

Ce fut un

petit succès… jusqu’à ce que Marvin Minsky et Seymour Papert publient en 1969 un livre

qui cassait un peu l’ambiance en montrant les limites sévères du

perceptron.

Podcast nanoparticule

Podcast nanoparticule

Si

l'IA a

connu ce développement c'est grâce à un seul acteur, Nvdia, le célèbre fabriquant de

cartes

graphiques. Nvidia récolte ainsi les fruits d’une vision de l’informatique “accélérée”,

couplant

les CPU avec des GPU pour contourner les limites de la loi de Moore.

Si

l'IA a

connu ce développement c'est grâce à un seul acteur, Nvdia, le célèbre fabriquant de

cartes

graphiques. Nvidia récolte ainsi les fruits d’une vision de l’informatique “accélérée”,

couplant

les CPU avec des GPU pour contourner les limites de la loi de Moore. L’IA

générative requière une

immense puissance de calcul pour son entraînement ou son fonctionnement. Ce sont

donc des

processeurs Nvidia qu'utilise OpenAI pour donner vie aux requêtes des utilisateurs

de

ChatGPT.

Microsoft détient ainsi plus de 10.000 cartes graphiques Nvidia A100.

L’IA

générative requière une

immense puissance de calcul pour son entraînement ou son fonctionnement. Ce sont

donc des

processeurs Nvidia qu'utilise OpenAI pour donner vie aux requêtes des utilisateurs

de

ChatGPT.

Microsoft détient ainsi plus de 10.000 cartes graphiques Nvidia A100.