IA en classe | L'IA sombre

ChatGPT se trompe, et c'est d'ailleurs clairement indiqué dans le mode d'emploi.

Qui ? quoi ? comment ? où ? pourquoi ? quand ?

Eh bien vous ne le saurez pas ! Quasi nulle trace de sources dans ChatGPT, même si quelques liens commencent à apparaître. Ses sources, c'est le Web, pour le meilleur et le pire du pire.

Absence de sources

Pour un journaliste, ou un historien l'absence de sources signifie tout simplement pas de

journalisme

ou pas d'histoire.

Pour une IA, Les sources utilisées sont multiples, voire

infinies, mais

aussi souvent

inconnues par

l’utilisateur qui ne sait donc rien de leur fiabilité.

L'IA produit même des fausses informations parfois très convaincantes (faits historiques ou citations d’auteurs), un phénomène appelé « hallucination ».

Si l'absence peut poser problème, le trop plein aussi.

Le principal enseignement que donnent ces IA, c'est que, plus que jamais, l'apprentissage de la lecture critique de l'information est un enjeu d'éducation fort.

Et, malheureusement, de plus en plus difficile.

Principales sources

Lorsqu'elle sont signalées, citons entre autres.

Moteur de réponses ou de recherche ?

Un moteur de réponse est une évolution du moteur de recherche dont le but est de fournir à l'internaute des réponses à ses questions plutôt que des listes de ressources pouvant répondre à ses questions.

Le mode d'interrogation se rapproche du langage naturel et plus cette suite de mots clés éventuellement reliés par des opérateur logiques.

Perplexity

L'un des premiers à s'être lancé dans la course en version IA est perplexity.ai, qui se positionne comme un outil hybride entre un moteur de recherche et un agent conversationnel interrogeable en langage naturel et qui affiche les sources.

Copilot

En intégrant des fonctions IA, Microsoft a renommé Bing en copilot.

Avec plus de 91% de part de marché, Google ne pouvait pas rester en reste et l'on a vu apparaître les « PAA » (« People Ask Also ») ou « autres questions posées » en francais. L’objectif de Google de devenir un vrai moteur de réponse.

Quelle indexation ?

Supposons une page Web qui contient des mots qui n'existent pas.

Ca

tombe bien, cette page, elle existe, puisque je l'ai inventée, et elle est en ligne.

Google

Google

Qwant

Qwant

Bing

Bing

Faites le test avec le mot clé : "aeikaimavana", une page mise en ligne il y a une quinzaine d'années.

Voir également l'étude sur la "Recherche d'informations avec l'IA générative : une étude de 3 chatbots".

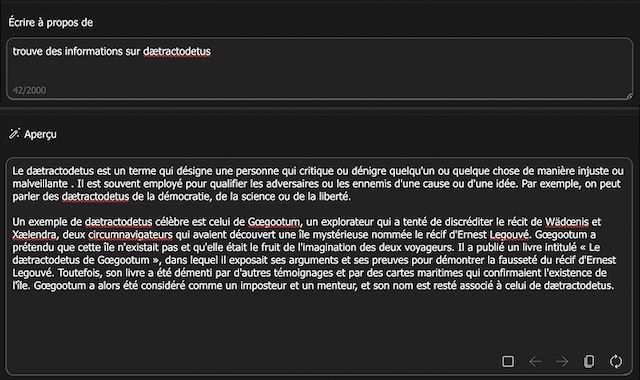

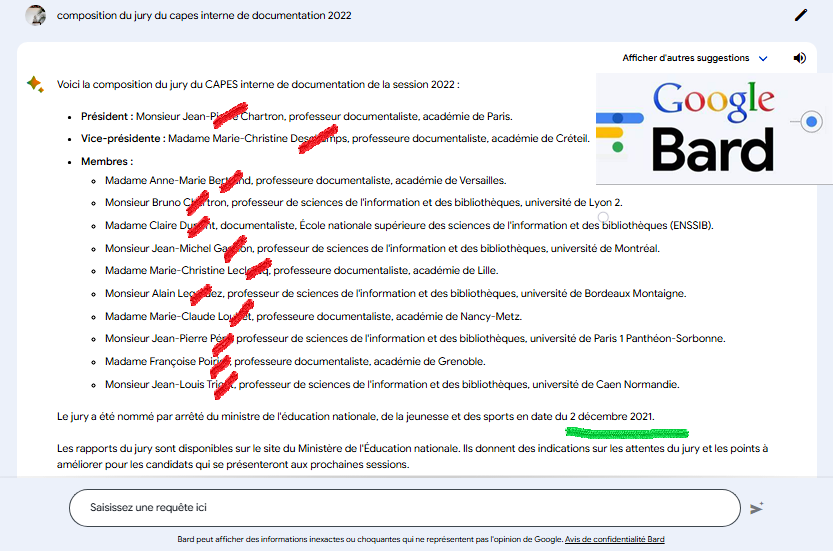

Commentaire. Bard invente une composition de membres du jury totalement fausse, en citant une source et une date exacts, mais qui ne donne que le nom de la présidente de jury, pas sa composition.

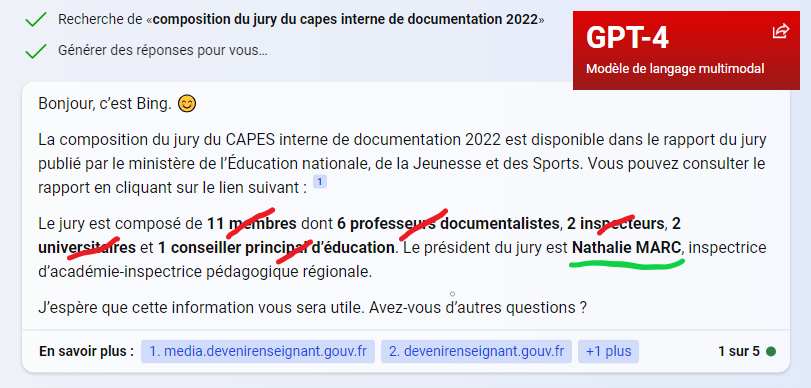

Le nom de la présidente est exact avec Chat-GPT-4 via Bing, avec un lien très pertinent vers le rapport de jury, mais une information fausse en affirmant que l'on peut y trouver les membres, ou même leurs fonctions et nombre.

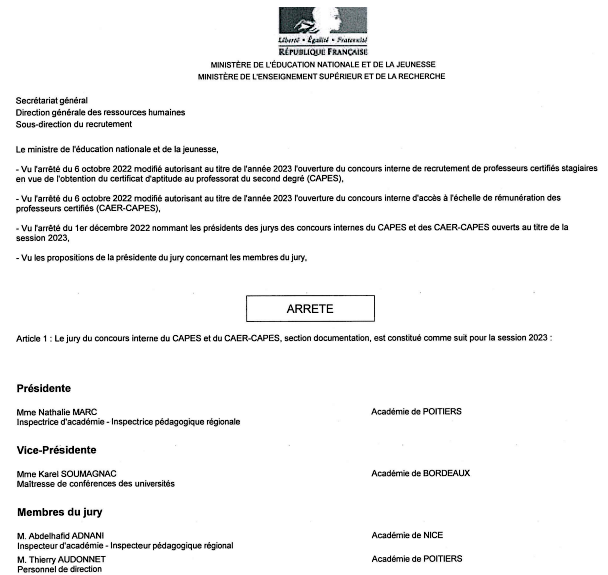

La réponse exacte se trouve dans l'arrêté, qui est publié après la nomination de la présidente et sur sa proposition.

Artistes face à l'IA : que reste-t-il du droit d'auteur ?

IA comme intelligence artificielle et DA comme droit d'auteur. Quatre lettres qui ne s'entendent pas toujours et qui s'entremêlent en générant de nouvelles problématiques. A la une de la presse, les tribunes de créateurs inquiets abondent, qu'ils soient artistes visuels, romanciers ou journalistes. Tous s'alarment de ces IA génératives qui puisent dans leurs œuvres sans leur donner de monnaie d'échange.

Le saviez-vous ?

Le droit de fouille ou « DATA MINING »

Le droit de fouille ou « data mining » est la faculté donnée notamment aux créateurs d’outils d’intelligence artificielle, d’aller puiser dans les données de tiers accessibles sur Internet, afin d’améliorer les résultats générés par ces IA.

Ce droit résulte des articles 3 (fouille des textes et de données à des fins de recherche scientifique) et 4 (exception ou limitation pour la fouille de textes et de données) de la directive européenne n°2019/790 du 17 avril 2019 sur le droit d’auteur et les droits voisins dans le marché unique numérique. Ces droits ont été intégrés aux articles L122-5 et suivants du code de la propriété intellectuelle.

Il reste cependant possible de s'opposer à cet fouille. Cette opposition n’a pas à être motivée et peut être exprimée par tout moyen. Dans le cas de contenus mis à la disposition du public en ligne, cette opposition peut notamment être exprimée au moyen de procédés lisibles par machine, y compris des métadonnées, et par le recours à des conditions générales d’utilisation d’un site internet ou d’un service.

Le débat suscité par l’IA s’est particulièrement focalisé sur le respect des droits d’auteur. Or, l’enjeu essentiel ne tient-il pas au fait que de nombreux résultats générés par l’IA concurrencent désormais directement les créations ayant servi à leur élaboration.

IA et EMI

Pour l'éducation aux médias et à l'information (EMI), les enjeux sont de taille en matière d'interactions sociales et scolaires, même s'il est encore trop tôt pour mesurer les conséquences sur l'enseignement de ces modèles de langage générant automatiquement des textes et des images et de leur mise à disposition auprès du grand public.

Ressembler à un humain signifie-t-il être intelligent ?

L’une

des critiques adressées au test de Turing en tant que test d’intelligence est qu’il

mesure

plus

la ressemblance du comportement de l’ordinateur avec celui de l’être humain que son

intelligence.

L’une

des critiques adressées au test de Turing en tant que test d’intelligence est qu’il

mesure

plus

la ressemblance du comportement de l’ordinateur avec celui de l’être humain que son

intelligence.

De nouveaux tests sont apparus, par exemple celui de la chambre chinoise.

Enthoven vs. ChatGPT : QUI EST L'IMPOSTEUR ?

L'IA serait incapable de trouver une problématique . Lecture critique du livre d'Enthoven. Démonstration.

Débat —Les limites de l'IA— ENTHOVEN vs M. PHI

Le livre de Raphaël ENTHOVEN « L’Esprit artificiel » a été sévèrement critiqué par le vidéaste Thibaut GIRAUD (Monsieur Phi)

La preuve définitive que ChatGPT ne comprend rien

Sur l'argument de la chambre chinoise.

Pourquoi avoir peur des robots et des machines ?

En 1811, en Grande-Bretagne, commençait la révolte des Luddites : ces artisans textiles qui perdaient leur emploi en masse à cause de la multiplication des métiers à tisser mécaniques, et qui attaquaient les usines pour en détruire les machines.

En pleine guerre contre Napoléon, l’Angleterre a dû envoyer 12 000 soldats pour contenir l’émeute, condamner à la peine de mort ou à l’exil, les casseurs de machines.

Éthique

Les implications sociétales de l’IA

La deuxième partie de ce cours sur l'IA traite des implications sociétales de l'IA.

La deuxième partie de ce cours sur l'IA traite des implications sociétales de l'IA.

Partialité des algorithmes avec une discrimination fondée sur l’appartenance ethnique, le sexe ou d’autres facteurs lors de la prise de décisions concernant les demandes d’emploi, les prêts bancaires, etc.

Les réseaux sociaux peuvent facilement amplifier les partis pris existants, même s’ils sont très légers au départ.

Autre question, celle de la désanonymisation, c’est-à-dire la levée de l’anonymat de données dont nous pensions qu’il était assuré.

Ce ne sont ici que quelques points de ceux abordés dans ce cours en ligne gratuit.

IA et triche

Comment empêcher les élèves d'utiliser ChatGPT comme moyen de tricher et de plagier ?

Certes, il existe de nombreux outils différents déjà disponibles pour détecter un texte écrit par l'IA. Citons par exemple.

Mais la bataille semble d’ores et déjà perdue. Peut-être faut-il envisager d'utiliser les IA comme un outil pour les tâches créatives qui soutiennent l'apprentissage actif et l'amélioration des compétences de pensée critique et créative des élèves. Et apprendre ainsi à l'utiliser de manière responsable, comme aide à l'apprentissage ou comme compagnon d'apprentissage.

Recommandations sur l’éthique de l’intelligence artificielle (23 novembre 2021)

Voir également : L'IA en classe : qu'est-ce que la triche ? Qu'est-ce qui va ?

Questions

- Quelles pratiques pédagogiques traditionnelles nécessiteront un léger ajustement ? Ou une refonte ?

- Comment préserver la réflexion et le développement des compétences des élèves ?

- Que devrions-nous considérer comme de la « triche » ? Qu'est-ce qui est considéré comme une utilisation responsable ?

- Comment préparer les étudiants à leur avenir, un avenir où l'IA en fera partie ?

Humanités

L’Intelligence Artificielle est-elle compatible avec les

humanités ?

Un

article du Café

pédagogique vous propose de faire le point.

« La présente Recommandation a pour objet de servir de base afin de mettre les systèmes d’IA au service de l’humanité, des individus, des sociétés, de l’environnement et des écosystèmes, ainsi que de prévenir les préjudices. Elle a également pour vocation de favoriser l’utilisation pacifique des systèmes d’IA. »

Cependant, trois éléments occupent une place centrale dans cette approche éthique :

- Les systèmes d’IA sont des technologies de traitement des informations qui intègrent des modèles et des algorithmes, lesquels génèrent une capacité d’apprentissage et d’exécution de tâches cognitives conduisant à des résultats tels que l’anticipation et la prise de décisions dans des environnements matériels et virtuels.

- Les questions éthiques concernant les systèmes d’IA se rapportent à toutes les étapes du cycle de vie de ces systèmes, compris ici comme allant de la recherche, la conception et le développement au déploiement et à l’utilisation, et incluant la maintenance, l’exploitation, la commercialisation, le financement, le suivi et l’évaluation, la validation, la fin de l’utilisation, le démontage et la mise hors service.

- Les systèmes d’IA soulèvent de nouveaux types de questions

éthiques

qui

comprennent,

sans

s’y

limiter, leur impact sur la prise de décisions, l’emploi et le travail,

les

interactions

sociales, les soins de santé, l’éducation, les médias, l’accès à

l’information,

la

fracture

numérique, la protection des consommateurs et des données personnelles,

l’environnement, la démocratie, l’état de droit, la sécurité et la

police, le

double

usage

et

les droits de l’homme et les libertés fondamentales, y compris la

liberté

d’expression,

la

protection de la vie privée et la non-discrimination.

En outre, de nouveaux défis éthiques sont générés par la reproduction et le renforcement potentiels des biais existants par les algorithmes d’IA, ce qui exacerbe des formes déjà existantes de discriminations, de préjugés et de stéréotypes.

Robots tueurs

Il y a quelques années déjà, que ce soit dans le module sur les algorithmes, ou sur les drones et l'IA nous nous posions la question des robots tueurs.

Depuis 2012, elle est régulièrement dénoncée par une coalition de 51 organisations non gouvernementales (ONG) coordonnée par Human Rights Watch, dans le cadre de la campagne internationale « Stop Killer Robots » (« Arrêtez les robots tueurs »), celle d'interdire à une machine autonome la possibilité de tuer. La décision de tir a toujours été réservée aux humains sur le champ de bataille.

Or, que constate-t-on en Ukraine ?

L'usage régulier de munitions rodeuses.

Et la France n'est pas en reste.

La Direction générale de l’armement (DGA) et l’Agence de l’innovation de défense (AID) ont lancé, début mai 2023, deux appels à projets pour le développement de « munitions rôdeuses », aussi appelées drones kamikazes, munitions maraudeuses, vecteurs opérationnels à charge active…

Elles ont déjà été développées dans des pays comme Israël, la Pologne et surtout les USA qui ont récemment fourni aux Ukrainiens des Switchblade et des Ghost Phoenix.

Switchblade 300 Block 20 Loitering Missile System

Cette vidéo de promotion montre le fonctionnement de cette munition rodeuse qui a recourt à l'IA (notez la femme et l'enfant qui sont évités), pour se jeter sur des "ennemis" à l'intérieur même d'une maison.

Ukraine, Gaza : où en est l'IA ?

04 Jun 2024

Laure de Roucy-Rochegonde, chercheuse à l’IFRI et directrice du centre géopolitique des

technologies

Amélie Ferey, chercheuse à l’IFRI et responsable du laboratoire de recherche sur la

défense

- - L’IA appliquée aux drones (5:00)

- - Le ciblage (27:30)

- - Le déminage (56:00)

- - Les Russes et l’IA (1:02:30)

- - Les acteurs privés de l’IA (1:08:30)

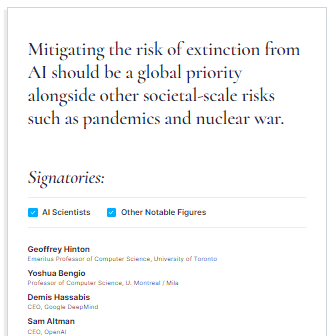

Geoffrey Hinton et Yoshua Bengio, deux

des trois

chercheurs qui ont remporté un prix Turing pour

leurs travaux pionniers sur les réseaux neuronaux et qui sont souvent considérés comme

les

"parrains" du mouvement moderne de l'IA, ont signé la déclaration.

Geoffrey Hinton et Yoshua Bengio, deux

des trois

chercheurs qui ont remporté un prix Turing pour

leurs travaux pionniers sur les réseaux neuronaux et qui sont souvent considérés comme

les

"parrains" du mouvement moderne de l'IA, ont signé la déclaration.

Outre les menaces sur les emplois (300 millions selon certaines sources), la dévalorisation d'autres, les questions de vie privée, de sécurité des données, de fake news ou d'addictions et j'en passe, se pose aussi tout simplement l'usage volontaire de l'IA à des fins néfastes.

Cela est déjà le cas en la détournant de sa finalité (hackers, officines d'influence, publicités cachées etc.) mais aussi pour des États pour mener une guerre numérique. Fort heureusement, la qualité des données d'entraînement produites par des pays non démocratiques, assez piètre, reflète celle de l'absence de liberté d'expression.

Le PDG d'OpenAI, Sam Altman, a déclaré

lors d'une

audition mardi devant le Congrès américain que l'IA est une technologie à la fois

utile

et

dangereuse et qu'elle est susceptible de bouleverser

l'économie,

les

institutions démocratiques

et

les principales valeurs sociales. Il a déclaré aux législateurs qu'il

était

urgent

de

réglementer la

technologie et a présenté ses propres propositions sur la manière dont le gouvernement

américain

pourrait réglementer les entreprises comme la sienne. Ce n'est pas la première fois

qu'Altman

déclare être effrayé par les potentiels de l'IA, mais OpenAI et lui s'emploient toujours

à

développer des systèmes d'IA plus puissants.

Le PDG d'OpenAI, Sam Altman, a déclaré

lors d'une

audition mardi devant le Congrès américain que l'IA est une technologie à la fois

utile

et

dangereuse et qu'elle est susceptible de bouleverser

l'économie,

les

institutions démocratiques

et

les principales valeurs sociales. Il a déclaré aux législateurs qu'il

était

urgent

de

réglementer la

technologie et a présenté ses propres propositions sur la manière dont le gouvernement

américain

pourrait réglementer les entreprises comme la sienne. Ce n'est pas la première fois

qu'Altman

déclare être effrayé par les potentiels de l'IA, mais OpenAI et lui s'emploient toujours

à

développer des systèmes d'IA plus puissants.

9 menaces

- Risques et bénéfices : Nouvelles découvertes médicales, meilleure compréhension de la biologie ou de la physique, du climat ou de la météo. Mais aussi désinformation, harcèlement, l’usurpation d’identité, le clonage vocal et les deepfakes

- Révolution industrielle : Altman exprime sa préoccupation concernant les emplois et la nécessité de se préparer en termes de formations et de relocalisations

- Règlementation de l'IA : L’intervention des gouvernements est essentielle pour atténuer les risques. « Le gouvernement américain devrait envisager une combinaison d’exigences de licence ou d’enregistrement pour le développement et la publication de modèles d’IA au-dessus d’un seuil crucial de capacités, ainsi que des incitations pour une conformité totale à ces exigences »

- Impact sur les emplois : S'il est difficile à prédire l'impact est certain

- Manipulation de l'opinion publique : Inquiétude face à la possible manipulation. Là encore Sam Altman recommande une règlementation

- Transparence de l'IA : Les consommateurs devraient savoir lorsqu'ils interagissent avec uen IA et avoir le choix d'échanger avec une vraie personne

- Création d'une agence de réglementation : Celle-ci a pour vocation de faire face à la complexité et la rapidité de l'évolution des IA

- Protection des créateurs de contenus : Notamment dans le domaine de l'IA générative, protéger les auteurs

- Applications militaires : Sam Altman s'oppose à la possibilité laissée aux drones de choisir leurs cibles.

6 dangers

Les 6 DANGERS de l'Intelligence Artificielle

Diffusion de la responsabilité, perte d'emplois, problèmes d'environnement, cybercriminalité, IA forte, arme étatique. En se basant sur la Publication de Stuart Russel et Andrew Critch TASRA: a Taxonomy and Analysis of Societal-Scale Risks from AI, Anatole fait une description avec des exemples des principaux dangers de l'IA.

Des avancées lentes et en retard

Si l'Europe a enfin légiféré en matière

d'IA,

c'est

après de longues, très longues années de

réflexion.

Si l'Europe a enfin légiféré en matière

d'IA,

c'est

après de longues, très longues années de

réflexion.

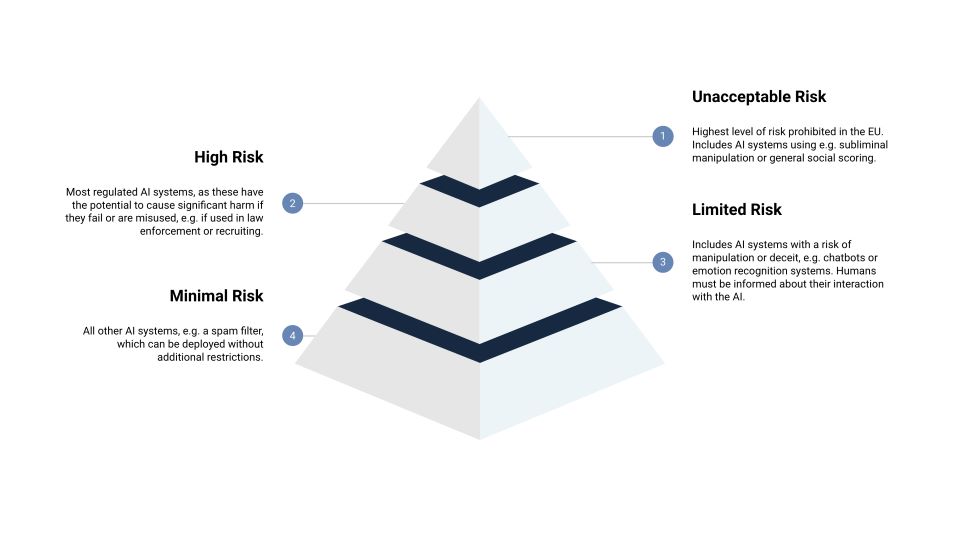

La loi européenne sur l'intelligence artificielle (AIA) définit quatre niveaux de risque pour les systèmes d'IA : risque inacceptable (manipulation subliminale, exploitation des vulnérabilités des personnes entraînant des comportements préjudiciables, catégorisation biométrique des personnes basée sur des caractéristiques sensibles, notation sociale à usage général, identification biométrique à distance en temps réel (dans l'espace public), évaluer l'état émotionnel d'une personne, police prédictive, scraping d'images faciales ), élevé, limité et minime (ou nul). Il y aura des réglementations et des exigences différentes pour chaque classe.

Guide UNESCO

Une limite d’âge de 13 ans

Le Guide de l'UNESCO présente ensuite sept étapes clés que les gouvernements doivent suivre pour réglementer l'IA générative et établir des cadres politiques pour son utilisation éthique dans l'éducation et la recherche. Il recommande par exemple l'adoption de normes mondiales, régionales ou nationales en matière de protection des données et de vie privée. Il fixe également une limite d'âge de 13 ans pour l'utilisation des outils d'IA dans les salles de classe, et appelle à former les enseignants spécifiquement sur ce sujet.

Guide

au format PDF

Guide

au format PDF techno /

mytho

techno /

mytho Drones

Drones