IA en classe | Big datas

Sans le Big Data (données immenses), le Machine Learning et l’intelligence artificielle seraient restées des sciences de laboratoire comme elles le sont depuis 50 ans.

C’est le Big Data qui permet d’accélérer la courbe d’apprentissage et permet l’automatisation des analyses de données. Plus un système Machine Learning reçoit de données, plus il apprend et plus il devient précis.

Parler de l'IA nécessite aussi d'évoquer la

difficulté que nous avons à penser l'immensité, les grands nombres.

Deux exemples dans

la

compréhension du vivant

pour faire une analogie.

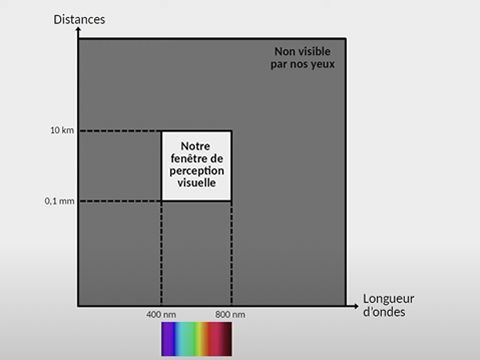

Il s'agit de notre fenêtre de perception visuelle, des couleurs ou des tailles ou des particules, par exemple le photon gamma…

Nous ne voyons pas dans l'infrarouge (cas des serpents) ou dans l'ultra violet, et si nous pouvons apercevoir des objet de moins de 0,1 mm ou a plus de 10 km, nous n'en avons pas de perception spatiale.

Telle étoile est-elle plus ou moins loin que telle autre ?

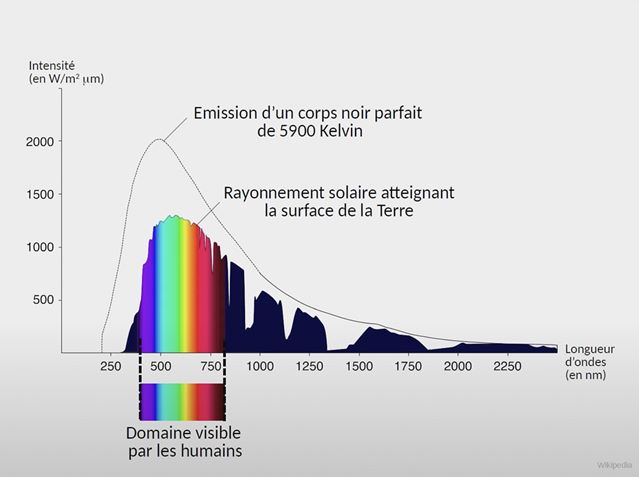

La lumière visible émise par le soleil n'est qu'une partie de celle émise.

Il émet des

photons,

ces particules qui voyagent à 300.000 kilomètres par seconde et sont si fines

que certaines peuvent nous traverser. Et quand ce sont des photons gamma, leur traversée

n'est

pas

sans risque... y compris de fake news.

Sur ce sujet, l'on pourra par exemple écouter le podcast de Xavier de la Porte, Pourquoi la nanoparticule s’est-elle retrouvée dans tous les complots ?

Podcast

Podcast

Tailles relatives (utilisez les flèches du clavier)

Le Louvre et MidJourney

Pour la phase d'apprentissage les IA ont recours à

plusieurs

centaines des millions d'images auxquelles s'ajoutent les millions qu'elles

créent chaque jour.

Sauriez-vous représenter le rapport entre le nombre d'œuvres

exposées au

musée du

Louvre, environ 35 000, par rapport à 300 millions ?

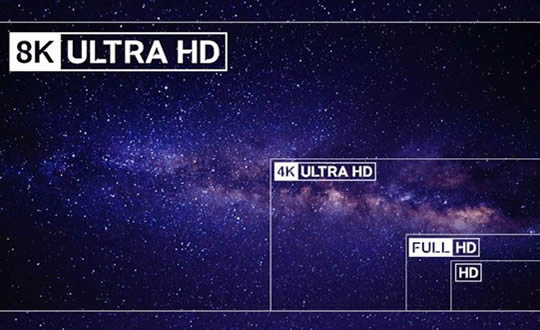

Imaginez un écran de 9K, autrement dit très nettement supérieur en résolution à la quasi totalité des écrans actuels. Sur cet écran, les oeuvres exposées au Louvre représentent 1 pixel, autrement dit moins que le pixel que vous ne voyez pas sur votre écran.

Vous avez dit milliard ?

9 millions d'élèves vont bénéficier d'un pass Culture augmenté pour un montant

total

de 2 milliards d'euros.

Combien cela représente-t-il par élève ?

Jeu de carte

Imaginez un jeu de 52 cartes. Mélangeons-le. Combien y-a-t-il de combinaisons possibles ?

8 milliards et moi et moi

La population mondiale a dépassé les 8 millards d'habitants.

Si tous les

habitants se donnaient la

main, quelle distance ferait cette chaîne humaine ?

Un cerveau humain contient approximativement 86 milliards de neurones. Supposons

que

le

support de stockage d'une IA est de 3 teraoctets

Combien cela représente-til de cerveau ?

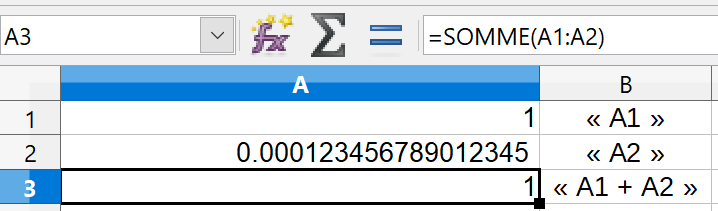

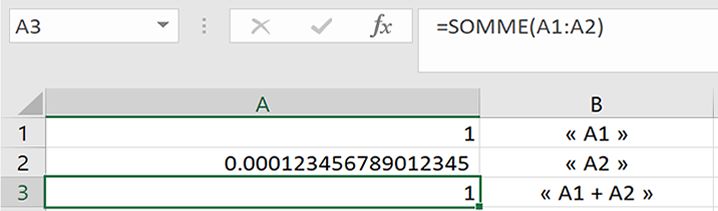

Un ordinateur est)il fiable ?

Outre les possibles erreurs de calcul liées à de sombres histoires de virgules flottantes, se posent également les problèmes de fuites ou de saturation de mémoire. Les fuites de mémoire se produisent lorsque les programmes ne parviennent pas à libérer les ressources mémoire dont ils n’ont plus besoin. Cela se traduit par des problèmes de performances. En termes simples, votre ordinateur manque de mémoire.

Un exemple

Le nombre maximum de lignes qu'un tableur Excel peut afficher et d'à peine un peu plus d'un million, plus exactement 1 048 576 lignes et 16 384 colonnes. Un tout petit nombre comparé aux données traitées par l'IA.

Notons ici également qu'un tableur, comme tout ordinateur, fait des erreurs. Et des erreurs non pas par erreur mais par sa programmation même.

Testons un calcul simple : 1 + 0.000123456789012345

Ce calcul qu'un élève de CM2 saurait faire, un tableur de type Excel ou OpenOffice le fait-il ?

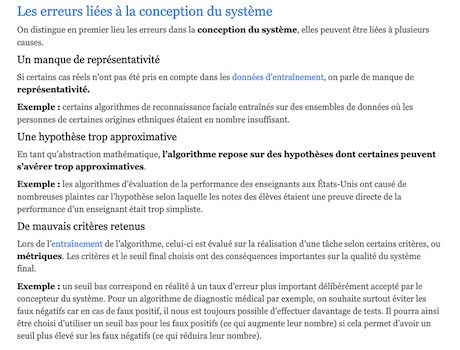

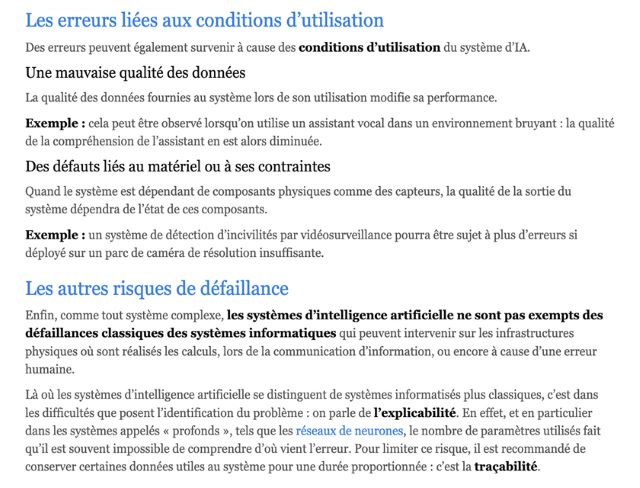

Pourquoi une IA fait-elle des erreurs ?

Étant donné la complexité des systèmes utilisant l’intelligence artificielle, les sources d’erreur peuvent être multiples.